«Антоніна»

І тут ми поговоримо не лише про зашкварних – пройдемося по нормальних теж, але не надто компетентних. А також про тих, хто просто лунає щодень із кожної праски.

16 Квіт 2024 18:00

36

«Антоніна»

У цьому проєкті співачка планує їздити на військові позиції та готувати разом з бійцями.

16 Квіт 2024 17:15

80

«Антоніна»

«На варті безпеки. Штурм» — серіал ICTV про спецпідрозділ СБУ. Бойовик як бойовик, якби раптом крізь маскулінні образи головних героїв не почали проступати персонажі ФСБ.

16 Квіт 2024 14:00

924

«Антоніна»

Якби не сториз Тіни Кароль і Меловіна, ми б і не знали, що сьогодні святкує свій день народження Алла Пугачова.

15 Квіт 2024 22:20

712

«Антоніна»

Телеведуча Марічка Падалко стала гостею нового випуску, що має назву «Я (не) держава». Разом із ведучими Наті Гресько, Катериною Мотрич та Ясею Кравченко вони говорили про те, як виховати свідомих громадян, і неочікувано (на перший погляд) дійшли до обговорення футболу.

15 Квіт 2024 19:15

357

«Антоніна»

Свіжу дискусію підвезли. Леся Ганжа, колишня журналістка, комунікаційниця, громадська діячка, а нині військовослужбовиця, змусила частину фейсбучної публіки обговорювати доречність фешенебельних івентів.

15 Квіт 2024 13:30

810

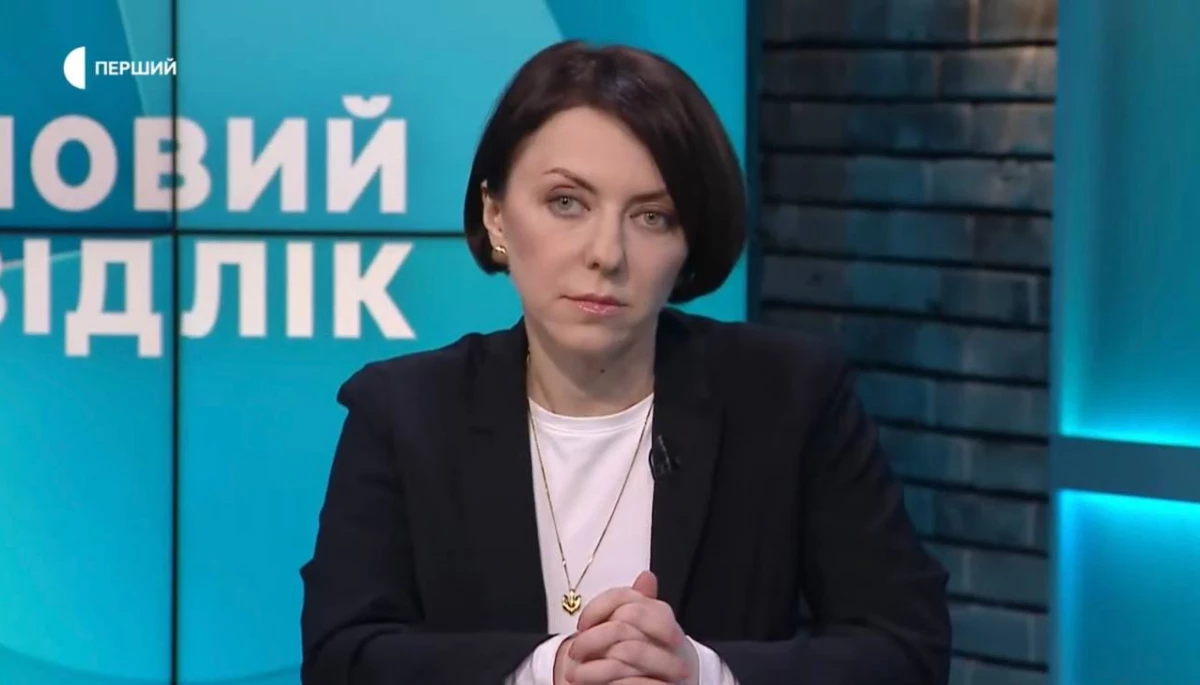

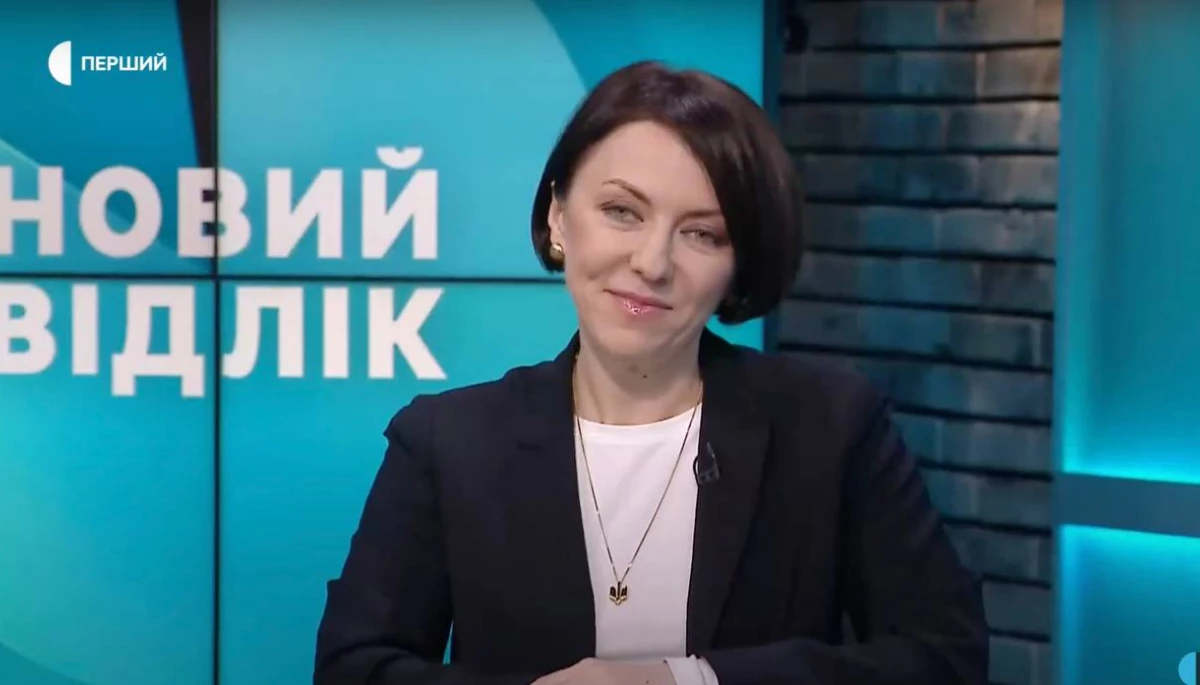

Ім'я юристки та колишньої заступниці міністра оборони відучора полощуть по всіх соцмережах.

13 Квіт 2024 15:35

3 109

«Антоніна»

Це сталося в нього ж на каналі, куди Емма прийшла давати інтерв'ю. Поговорили і про цензуру, і про марафон «Єдині новини» та «паторочей», які там працюють, і про роботу Слави як інтерв'юера.

13 Квіт 2024 13:00

928

Антоніна рекомендує

«Антоніна»

Ведучий каже, що дуже поважає видання «Букви» та читає регулярно, але новину про вечірку у Львові не зрозумів(взагалі-то матеріал вийшов у Lviv.mediа, «Букви» на нього посилалися). А ще обурюється наперед, мовляв, що його обов'язково засруть, якщо він збере мало грошей на івенті, який невдовзі вестиме у Польщі.

08 Квіт 2024 22:00

2 143

«Антоніна»

Доньку назвали Уляною. Щасливий батько подякував дружині за чудову командну роботу.

05 Квіт 2024 19:15

1 379

«Детектор медіа»

Один розмірковує про плани й проблеми у Росії, обзиває Путіна, а другий то з усім погоджується і майже весь час мовчить, то нагадує підписатися на соцмережі. Експерти, на яких ми заслужили. Про нещодавній стрім ведучих на ютубі та що з ним не так і поговоримо.

05 Квіт 2024 11:00

152

Ідеться про шоу ведучої «Моя історія». Це вже другий сезон, між іншим. І він, як і перший, дуже патріотичний.

03 Квіт 2024 09:00

871

Завантажити більше

Долучайтеся до Спільноти «Детектора медіа»!

Щодня наша команда готує для вас якісні й актуальні матеріали, які допомагають медіа в Україні ставати кращими. Ми будемо вдячні за будь-яку вашу підтримку. Ваші пожертви – це можливість робити ще більше.

Спільнота ДМ

«Антоніна»

Телеведуча Марічка Падалко стала гостею нового випуску, що має назву «Я (не) держава». Разом із ведучими Наті Гресько, Катериною Мотрич та Ясею Кравченко вони говорили про те, як виховати свідомих громадян, і неочікувано (на перший погляд) дійшли до обговорення футболу.

15 Квіт 2024 19:15

357

«Антоніна»

Це сталося в нього ж на каналі, куди Емма прийшла давати інтерв'ю. Поговорили і про цензуру, і про марафон «Єдині новини» та «паторочей», які там працюють, і про роботу Слави як інтерв'юера.

13 Квіт 2024 13:00

928

«Антоніна»

«На варті безпеки. Штурм» — серіал ICTV про спецпідрозділ СБУ. Бойовик як бойовик, якби раптом крізь маскулінні образи головних героїв не почали проступати персонажі ФСБ.

16 Квіт 2024 14:00

924

«Антоніна»

У цьому проєкті співачка планує їздити на військові позиції та готувати разом з бійцями.

16 Квіт 2024 17:15

80

«Антоніна»

Якби не сториз Тіни Кароль і Меловіна, ми б і не знали, що сьогодні святкує свій день народження Алла Пугачова.

15 Квіт 2024 22:20

712

«Антоніна»

Перевтілення Мірошниченка та Арзуманяна нам обіцяють уже цієї п'ятниці, тобто 12 квітня. У цьому випуску команди-учасниці покажуть театральні номери та заспівають пісень із запрошеними гостями.

11 Квіт 2024 21:45

101

«Антоніна»

Класична історія. Можна роками працювати ведучою на телебаченні, але по-справжньому прославитись за одну хвилину.

11 Квіт 2024 14:00

3 410

«Антоніна»

В оригіналі вона так і називається — Civil War, але на фразу «Громадянська війна» у нас реагують якось не дуже позитивно. В прокат стрічку випускає компанія Green Light Films.

12 Квіт 2024 09:00

786

«Антоніна»

Ну що, припиняємо обговорювати Булгакова та Оксану Линів та переходимо на новий рівень.

11 Квіт 2024 15:30

2 836

«Антоніна»

Не такої слави чекала головна державна інспекторка Львівської митниці Юлія Дрига, коли хвалилася відомому тікток-блогеру Ніколасу Кармі своїми аксесуарами.

12 Квіт 2024 20:20

1 639

«Антоніна»

Свіжу дискусію підвезли. Леся Ганжа, колишня журналістка, комунікаційниця, громадська діячка, а нині військовослужбовиця, змусила частину фейсбучної публіки обговорювати доречність фешенебельних івентів.

15 Квіт 2024 13:30

810

Ім'я юристки та колишньої заступниці міністра оборони відучора полощуть по всіх соцмережах.

13 Квіт 2024 15:35

3 109

«Антоніна»

Інколи заходиш на ютуб і бачиш відео з написами: «Україні доведеться на це піти», «Буде ще важче, ніж зараз», «Скоро буде два масовані ракетні обстріли?». Хочеться його закрити і лягти в помиральну яму. Про канали, які викладають відео з такими обкладинками, і поговоримо.

10 Квіт 2024 16:30

268

Ідеться про шоу ведучої «Моя історія». Це вже другий сезон, між іншим. І він, як і перший, дуже патріотичний.

03 Квіт 2024 09:00

871